整理了chatgpt微调所需要的测试资源数据,按照fine-tuning的格式生成的数据集。可以直接 fine_tunes.create -t 使用。 微调完毕后可以 -p 回答结果。 其中包含三四百条数据。 适合测试openai自定义模型的人群使用。

”openai chatgpt chatgpt微调 openai微调 fine-tuning“ 的搜索结果

Java调用openai微调Fine-tuning实战示例

GPT推出了Fine-tune微调模型,让我们可以基于自己的数据,对GPT进行微调训练。这里不讲述概念,因为网上都是概念,这里直接上实操。下面我们根据Openai官方文档,来做基于gpt-3.5-turbo进行微调训练。

3.在仍然需要Fine-Tuning的情况下,最初的prompt-engineering不会浪费,在微调数据中使用好的prompt(或者将prompt chaining/tool和Fine-Tuning结合),有助于我们看到最好的结果。如果您已经优化过prompt,模型依然有...

要使用OpenAI的微调技术来训练自己的专有模型,您需要遵循以下步骤:获取和准备数据集:首先,您需要准备自己的数据集。可以使用公共数据集,也可以使用自己的数据集。数据集需要以特定格式(如JSONL)进行存储,...

而从generative pre-training(生成式预训练)到discriminative fine-tuning(判别微调)的过程是一个对泛化特征进行面向任务的特化的过程。对于初始化过程,我们可以称自己的网络为目标网络,训练好的模型对应网络...

网址:https://platform.openai.com/finetune选择其中心血管科中的部分数据进行微调 微调需要进行付费,越多收费越多,并且的数最多为dataframe导入csv文件 提取样本 jsonl格式数据构建 jsonl数据导出 点击...

微调fine-tuning.pdf微调fine-tuning.pdf微调fine-tuning.pdf微调fine-tuning.pdf

chatgpt微调/fine-tuning测试资源 整理了chatgpt微调所需要的测试资源数据,按照fine-tuning的格式生成的数据集。可以直接 fine_tunes.create -t 使用。 微调完毕后可以 -p 回答结果。 其中包含三四百条数据。 适合...

微调(Fine-tuning)是指在深度学习领域中,特别是针对预训练模型的一种训练策略。预先训练好的模型通常是在大规模无标注数据上通过自监督学习得到的,它们具有对一般自然语言结构的良好理解能力。微调则是指在预...

微调通过训练比提示中更多的示例来改进小样本学习,让您在大量任务中取得更好的结果。对模型进行微调后,您将不再需要在提示中提供示例。这样可以节省成本并实现更低延迟的请求。Visit our请访问我们的定价页面,...

微调数据上传成功之后,开始使用,使用时,你会发现model只有 danvici 可选,danvici003啥的都不行。这里,要在 计算机管理中 跟设置java ...openAi fine-tuning 尝鲜结束。这里一次不能成功,得根据提示,多次上传。

近年来,迁移学习改变了自然语言处理领域的范式,对预训练语言模型(PLM)进行微调(fine-tuning)已经成为了新的范式。本文主要梳理了近期的预训练语言模型做fine-tuning的进...

迁移学习中的微调(Fine-tuning)是指在已经预训练好的模型基础上,对部分或全部模型参数进行调整以适应新任务。微调是在预训练模型的基础上进一步训练模型,使其适应新的任务或数据集。

俄语文本摘要的GPT-3微调_Fine-tuning GPT-3 for Russian Text Summarization.pdf

最早出现fine-tuning也是模型变大之后,使用原有模型的架构在新数据上训练成本过高且丢失了原有模型的能力,后来也是因为模型发展的规模增长远远超过硬件性能的发展,导致更加高效的微调技术出现。而当前最火热的...

上一步提交完训练任务之后,模型是需要一段时间来训练的,训练的时长取决于你的数据量大小、当下训练的任务数、openai的算力是否充足等等。像使用基础模型gpt-3.5,gpt-4一样,但这个模型名字是你自己训练的,所以...

大模型微调技术(Adapter-Tuning、Prefix-Tuning、Prompt-Tuning(P-Tuning)、P-Tuning v2、LoRA)

在深度学习过程中,获取数据集后,在训练自己的网络之前,用别人现有的网络进行fine-tuning(微调),然后训练。在实践中,由于数据集不够大,很少有人从头开始训练网络,常见的做法是使用预训练的网络来重新fine-...

对斯坦福汽车数据集进行微调 使用 Caffe,在斯坦福汽车数据集上微调各种预训练模型。

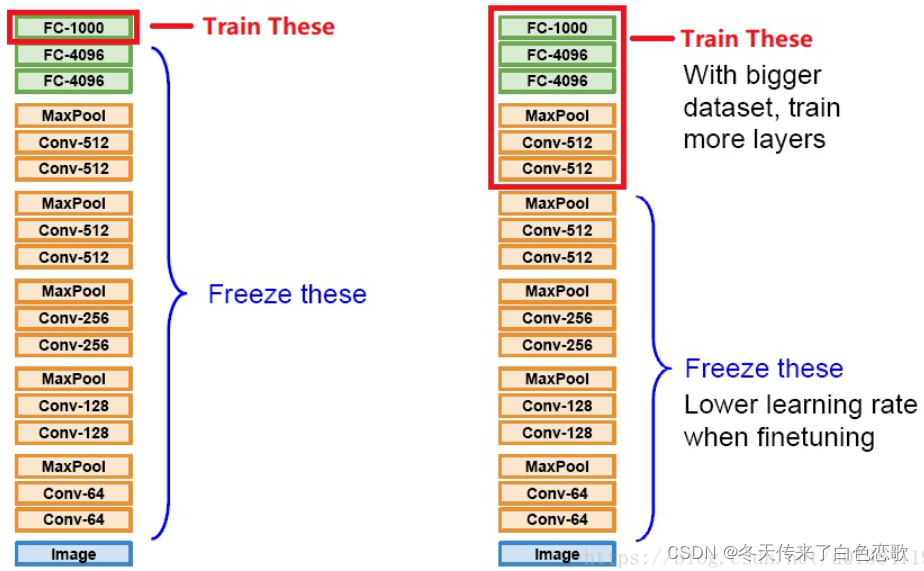

常见的做法是使用预训练的网络(例如在ImageNet上训练的分类1000类的网络)来重新fine-tuning(也叫微调),或者当做特征提取器。 以下是常见的两类迁移学习场景: 1 卷积网络当做特征提取器。使用在ImageNet...

一分钟搞懂 微调(fine-tuning)和prompt

微调是指在预训练模型(Pre-trained model)的基础上,针对特定任务或数据领域,对部分或全部模型参数进行进一步的训练和调整(Fine Tune)。预训练模型通常是在大规模数据集上训练得到的,具有一定的通用性和泛化...

Fine-tuning(微调)指的是在一个已经在大规模数据上预训练好的模型的基础上,进一步在特定任务上进行训练,以使模型适应该任务的特定数据和要求。这种方法允许我们充分利用预训练模型在大数据上学到的通用特征,...

虽然RAG提供了一种方式来给大型语言模型提供额外的信息,但还有另一种叫做微调(fine-tuning)的技术,也是给它更多信息的一种方式。特别是,如果你有的上下文比大型语言模型的输入长度或上下文窗口长度更大,那么...

一、什么是微调(Fine-tuning)?有什么好处?二、如何使用Fine-tuning API?三、使用Fine-tuning API 的注意事项五星上将麦克阿瑟曾经说过:“在懂微调的测试工程师面前,我...最近OpenAI 发表了GPT-3.5 模型的微调功能。

Fine-Tuning微调原理 如何在只有60000张图片的Fashion-MNIST训练数据集中训练模型。ImageNet,这是学术界使用最广泛的大型图像数据集,它拥有1000多万幅图像和1000多个类别的对象。然而,我们经常处理的数据集的...

推荐文章

- c语言链表查找成绩不及格,【查找链表面试题】面试问题:C语言学生成绩… - 看准网...-程序员宅基地

- 计算机网络:20 网络应用需求_应用对网络需求-程序员宅基地

- BEVFusion论文解读-程序员宅基地

- multisim怎么设置晶体管rbe_山东大学 模电实验 实验一:单极放大器 - 图文 --程序员宅基地

- 华为OD机试真题-灰度图恢复-2023年OD统一考试(C卷)-程序员宅基地

- 【机器学习】(周志华--西瓜书) 真正例率(TPR)、假正例率(FPR)与查准率(P)、查全率(R)_真正例率和假正例率,查准率,查全率,概念,区别,联系-程序员宅基地

- Python Django 版本对应表以及Mysql对应版本_django版本和mysql对应关系-程序员宅基地

- Maven的pom.xml文件结构之基本配置packaging和多模块聚合结构_pom <packaging>-程序员宅基地

- Composer 原理(二) -- 小丑_composer repositories-程序员宅基地

- W5500+F4官网TCPClient代码出现IP读取有问题,乱码问题_w5500 ping 网络助手 乱码 send(sock_tcps,tcp_server_buff,-程序员宅基地